Twitch KI Analyse Tool bauen !wasmachenwir !gründung !naturtreul !idealo

KI-gestützte Twitch-Analyse: Reichweitenprognose und Zuschauerverhalten

Eine KI wird genutzt, um Twitch-Daten zu analysieren und ein Tool zur Reichweitenprognose zu erstellen. Die Analyse konzentriert sich auf die Korrelation zwischen Reichweite, Zuschauerverhalten und Engagement. Kleinere Streamer haben eine höhere Watchtime pro Viewer. Die Chataktivität beeinflusst die Watchtime nur indirekt. Ziel ist es, Erkenntnisse für Influencer-Marketing zu gewinnen und Livestreaming-Events besser zu planen.

Begrüßung und Themenvorstellung

00:00:00Der Stream beginnt mit dem Abspielen eines Songs von Sido und einer Begrüßung der Zuschauer. Es folgt ein kurzer Austausch über persönliche Befindlichkeiten und frühere Live-Sessions. Thematisch wird die Notwendigkeit von mehr 'coolem Content' angesprochen, wobei IRL-Formate unter der Woche eher abgelehnt werden. Es wird die Arbeit an einer Instagram-Story erwähnt. Ein Zuschauer namens Maurizio sorgt für Belustigung und Irritation mit anzüglichen Nachrichten, was die Frage aufwirft, wie man mit solchen Kommentaren umgehen soll. Es wird die Idee eines autoritären, aber authentischen Streams betont, in dem auch Kritik an Zuschauern geäußert werden darf. Einleitend wird das heutige Vorhaben erklärt: Der Aufbau einer Datenbank und deren Analyse mit ChatGPT, um Fragen zu Streamer-Reichweiten und Zuschauerverhalten beantworten zu können. Ziel ist es, eine KI zu entwickeln, die bei der Preisgestaltung von Twitch-Kampagnen hilft, indem sie Reichweiten verschiedener Streamer vergleicht und Vorhersagen trifft.

Finanzielle Aspekte und Datenbeschaffung

00:18:47Es wird diskutiert, inwieweit man Reisekosten als Streamer absetzen kann, wobei betont wird, dass die Ausgaben im Verhältnis zu den Einnahmen stehen müssen, um Probleme mit dem Finanzamt zu vermeiden. Die Daten von Twitch-Trackern werden als nicht ausreichend angesehen, da wichtige Informationen wie Watchtime und Live-Aufrufe fehlen. Daher wurden Streamer-Freunde um Exporte ihrer Daten gebeten. Die gesammelten Daten sollen in eine Excel-Tabelle eingepflegt und mit ChatGPT analysiert werden, um Zusammenhänge zu erkennen. Es wird erwähnt, dass die Programmierung nicht im Vordergrund steht, sondern der Fokus auf der Nutzung von ChatGPT liegt. Die KI soll später auch Variablen wie Jahreszeit und Streamer-Konstellation berücksichtigen können. Leon wird für seine Bemühungen gedankt, einen Clip zu erstellen, auch wenn es nicht geklappt hat. Es wird eine Liste der Streamer genannt, die bereits Daten geliefert haben, darunter Meloni, Strombok, Danny, JuniCats, und es wird gehofft, weitere Daten von Adam, Lika, Sarah und Hasi zu erhalten.

Interaktion mit Zuschauern und Vorbereitung

00:23:16Es wird ein Bild für LinkedIn erstellt, um die Live-Session anzukündigen und neue Zuschauer anzuziehen. Die Interaktion mit dem Chat wird gefördert, indem die Zuschauer aufgefordert werden, 'Hallo LinkedIn' zu schreiben. Es wird überlegt, wie man die Prompts bei ChatGPT am besten eingibt, um die gewünschten Ergebnisse zu erzielen, und die Möglichkeit in Betracht gezogen, die KI selbst nach Vorschlägen zu fragen. Ein Zuschauerwunsch nach einem Keller-Stream wird aufgrund von Bedenken bezüglich der Preisgabe der Adresse bei Kleinanzeigen-Verkäufen abgelehnt. Alternativ wird ein Stream zum Entmüllen des Kellers und zum Wegbringen von Wertstoffen in Erwägung gezogen. Die Bewerbung von Zuschauern wird erwähnt. Lausi wird als ewig Single beschrieben und seine Probleme mit seinem Auto werden angesprochen. Es wird überlegt, ob man die Sachen über Kleinanzeigen oder Flohmärkte verkaufen soll. Es werden Crypto-Investments angesprochen. Lausi hat den Drucker bekommen.

Anekdoten und Community-Interaktion

00:39:47Es wird eine Umfrage gestartet, um zu entscheiden, ob mit der KI-Arbeit begonnen werden soll oder ob noch weiter gechattet werden soll. Es wird eine Geschichte von einem Erlebnis im Englischen Garten erzählt, bei dem ein junger Mann Komplimente machte und aufdringlich wurde. Die Situation wurde gelöst, indem man sich im Eisbach treiben ließ, um dem Blick des Mannes zu entgehen. Es wird über die Größe des Bikinis gesprochen und die Notwendigkeit einer Laserbehandlung erwähnt. Es wird eine Instagram-Story über das Fahrradfahren erwähnt, bei der die Brüste wackelten, und die Diskussion darüber, ob man sie hochladen sollte. Sarah ermutigte dazu, sie hochzuladen, da man sowieso sexualisiert werde. Es wird betont, dass die Community höflich ist und keine anzüglichen Nachrichten sendet. Es wird der Bikini gezeigt und diskutiert, ob es sich um Unterwäsche oder ein Bikini-Höschen handelt. Es wird betont, dass die Arbeit am KI-Tool jetzt beginnt, da sich die Zuschauer sonst verarscht fühlen.

Datenbankaufbau und manuelle Dateneingabe

00:56:10Es werden Daten von verschiedenen Streamern wie Danny, Meloni, Juni und Strombok gesammelt, die ihre Exporte bereits zugesendet haben. Diese Daten müssen nun manuell in eine Datenbank eingefügt werden, was als eine kleine, aber notwendige Aufgabe beschrieben wird. Nach dem Einfügen der Daten in die Datenbank soll diese in Chattapiti hochgeladen werden, um die Zahlen analysieren zu lassen. Die Streamerin betont, dass ihre Vorgehensweise keine spezifischen IT-Kenntnisse erfordert, sondern vielmehr eine Problemlösungsorientierung. Es wird diskutiert, dass der Streaming-Titel für eine genauere Analyse wichtig wäre, um zwischen PC- und IRL-Streams zu unterscheiden, und die Möglichkeit einer manuellen Nachtragung dieser Information aus dem Twitch-Tracker wird in Betracht gezogen. Die Kategorie des Streams wird ebenfalls als wichtiger Faktor genannt, da sie sich während des Streams ändern kann, beispielsweise von IRL zu Just Chatting.

Manuelle Datenerfassung und Titel-Extraktion aus Twitch Tracker

01:00:18Es wird die Möglichkeit diskutiert, Titelinformationen manuell von Twitch Tracker zu extrahieren, was jedoch als aufwendig eingeschätzt wird. Alternativ wird die Frage aufgeworfen, ob es eine Möglichkeit gibt, diese Daten automatisiert zu exportieren. Die Community rät zur manuellen Dateneingabe, da die automatische Extraktion zu kompliziert erscheint. Die Streamerin beginnt, ihre eigenen Daten einzupflegen, um erste Rückschlüsse mit der KI zu ziehen und die Notwendigkeit der Datenerfassung zu prüfen. Es wird kurz überlegt, ob man Daten von Goutiz importieren könnte, aber die Idee wird verworfen, da der manuelle Prozess nicht viel Zeit in Anspruch nimmt. Nach dem Import der eigenen Daten werden auch die Daten von Juni in das System eingepflegt. Es wird festgestellt, dass die Kategorien der Streams nicht mitgezogen werden, was die Aussagekraft der Daten beeinflussen könnte, da IRL-Streaming sehr vielfältig sein kann.

Diskussion über synthetische Daten und Datenbankerstellung

01:09:24Die Diskussion dreht sich um die Verwendung synthetischer Daten, wobei die Streamerin betont, dass sie keine IT-Expertin ist und lediglich versucht, durch Ausprobieren und Anwendung von aufgeschnappten Ideen voranzukommen. Die Sinnhaftigkeit synthetischer Daten wird hinterfragt, da bereits echte Daten vorhanden sind. Es wird der Vorschlag gemacht, synthetische Daten zum Testen der Funktionalität zu verwenden. Die Streamerin sammelt Daten von verschiedenen Streamern, darunter Juni, Strombok und Danny, wobei Meloni eine unbrauchbare Canva-Datei geschickt hat. Die gesammelten Daten werden als Datenbank gespeichert und in ein Tool hochgeladen. Nach dem Hochladen der Daten in das Projekt wird die Community um Vorschläge gebeten, wie mit den Daten weiter verfahren werden soll. Es wird ein kalter Kaffee zubereitet, während auf Vorschläge gewartet wird.

Analyse der Twitch-Daten mit Chat-Tippity und Datensammlung

01:20:49Die Streamerin nutzt Chat-Tippity, um die Daten von verschiedenen Twitch-Streamern zu analysieren und ein Tool zur Reichweitenprognose zu erstellen. Sie fragt Chat-Tippity, ob es anhand der Aufrufe und des durchschnittlichen Zustands helfen kann, ein Tool für einen Forecast für die Reichweite der zukünftigen Streams der jeweiligen Personen zu erstellen. Es wird festgestellt, dass die Daten hauptsächlich aus Deutschland, Österreich und der Schweiz stammen. Die Streamerin kann die linke Seite des Tools nicht öffnen, was die Analyse einschränkt. Sie möchte im ersten Schritt die Daten verstehen und Zusammenhänge zwischen Reichweite und Zuschauerverhalten erkennen. Es wird überlegt, ob Zuschauer mit großer Reichweite länger zusehen als solche mit geringerer Reichweite. Der Fokus liegt auf der Korrelation und Kausalität der Daten. Es wird betont, dass die Analyse nicht perfekt sein muss und man sich schrittweise an die Thematik herantasten wird.

Ergebnisse der Datenanalyse und Optimierungspotenzial

01:29:37Die Analyse zeigt, dass kleinere Streamer eine höhere Watchtime pro Viewer haben. Die Streamerin äußert sich erfreut über die Ergebnisse, auch wenn ihre eigene Watchtime geringer ist. Es wird diskutiert, ob größere Streamer in die Analyse einbezogen werden sollten, was jedoch aufgrund fehlender Kontakte schwierig ist. Die Streamerin stellt fest, dass die Daten bis zu einer gewissen Größe repräsentativ sind. Es fällt auf, dass die Watchtime bei Danny und Juni identisch ist. Kleinere Kanäle haben ein höheres Engagement. Die Views pro Unique Viewer sind relativ konstant. Es wird festgestellt, dass größere Streams nicht automatisch zu mehr Rückkehr-Fuse-Profession führen. Die Analyse zeigt einen Abwärtstrend: Je größer der Stream, desto niedriger die Watchtime pro Person. Mittelgroße Streams (100-500 Zuschauer) scheinen optimal für hohe Watchtime pro Person zu sein. Zusätzliche Faktoren wie Tageszeit und Wochentag werden berücksichtigt. Die Frage wird aufgeworfen, ob die Chataktivität die Watchtime beeinflusst.

Chat-Engagement und Zusammenhänge mit der Watchtime

01:41:12Es wird diskutiert, ob die Chataktivität der Zuschauer die Watchtime beeinflusst. Es wird festgestellt, dass es keinen direkten Zusammenhang zwischen Chat-Nachrichten und Zuschauer-Watchtime gibt, aber im Großen und Ganzen kann man sagen, dass Streams mit mehr Zuschauern auch mehr Chat-Nachrichten haben. Die Analyse zeigt, dass der bloße Anteil der Chatter am Gesamtpublikum sogar leicht negativ mit der Watchtime pro Viewer korreliert. In großen Streams schreiben viele Zuschauer nur wenige Nachrichten, was die Verweildauer nicht erhöht. Es wird festgestellt, dass nur wer mehrfach schreibt, signifikant länger im Stream bleibt. Die Streamerin möchte wissen, ob sie nur Chatter oder Chat-Nachrichten zählen soll. Es wird vorgeschlagen, Chat-Nachrichten pro Unique Viewer als Engagement-Feature zu nutzen. Die Streamerin fragt, wie sie mit stillen Zuschauern umgehen soll, da diese in den Daten mit einbezogen werden.

Modellbau zur Reichweitenprognose und Erkenntnisse für Influencer-Marketing

01:48:05Es wird die Frage aufgeworfen, wie man Reichweiten frühzeitig prognostizieren und ein Modell dafür bauen kann. Die Streamerin gibt an, dass sie nicht weiß, ob das aktuelle Modell (O3) das richtige ist und dass sie keinen Spaß an Mathe hat. Es wird erklärt, dass 0,3 ein guter Wert ist. Die Streamerin möchte Strategien zur Entschärfung von Bias kennen. Es wird nach den wichtigsten Erkenntnissen aus dem Datensatz im Bezug auf Influencer gefragt. Sie möchte wissen, ob sie für Influencer-Marketing einen kleinen oder großen Streamer buchen sollte. Die Streamerin bittet um eine verständliche Antwort, da sie Marketingmanagerin ist und eine Entscheidung treffen muss. Die Analyse zeigt, dass große Streams zwar mehr Reichweite liefern, aber die Einbindung geringer ist als bei mittleren Kanälen. Mittelgroße Streams überzeugen bei Tiefe und Aktivität und bieten die beste Engagement-Qualität pro Kopf. Es werden Kennzahlen wie Brutto-Reichweite, Watchtime und Engagement-Score genannt.

Planung von Livestreaming-Events und Reichweitenanalyse

01:57:40Es soll mit der Datenbank die Reichweite von Livestreaming-Events vorab analysiert werden. Die Streamerin möchte der KI sagen können, welche Reichweite bei der Buchung von bestimmten Streamern für ein Event zu erwarten ist. Es wird festgestellt, dass es Unterschiede bei der Watchtime und den Liveaufrufen je nach Größe des Streamers gibt. Bei der Planung von Livestreaming-Events müssen kleinere, mittelgroße und große Streamer unterschieden werden, da dies Auswirkungen auf die Aufrufe hat. Es werden mehr Daten benötigt. Es wird festgestellt, dass der Wochentag eine Rolle spielt: Mittwoch und Freitag liefern die höchste Watchtime, während samstags die Zuschauerzahlen steigen, aber die Chataktivität sinkt. Die Streamerin möchte eine Zusammenfassung der Erkenntnisse erhalten und dann den Chatbot in Richtung Livestreaming-Event-Planung lenken. Sie möchte wissen, welche Gedanken der Chatbot zu der Frage hat, wie man Kunden vorab sagen kann, mit welcher Reichweite sie bei der Teilnahme mehrerer Streamer an einem Livestream rechnen können.

Datenanalyse und Fehlererkennung im Umgang mit Stream-Daten

02:09:54Es wird festgestellt, dass die KI-Analyse der Stream-Daten unvollständig ist, da ausgeblendete Streams und ältere Daten als die letzten 30 Tage nicht berücksichtigt wurden. Dies führt zu der Erkenntnis, dass die bisherigen Datenexporte möglicherweise fehlerhaft waren und der Linzathlon-Stream vom 24. Mai fälschlicherweise nicht einbezogen wurde. Es wird der Wunsch geäußert, den Titel jedes Streams für eine genauere Auswertung zu erfassen, da die KI Multistream-Events offenbar anhand der Namen im Titel erkennt. Es wird diskutiert, dass die Zahlen eines Multistreams nicht blind übernommen werden können, da die Zuschauerzahlen nur die des eigenen Kanals widerspiegeln, während die Chatnachrichten von allen Teilnehmern stammen. Die Notwendigkeit, Multistream-Events in der Analyse korrekt zu identifizieren und zu berücksichtigen, wird hervorgehoben, um Kunden keine falschen Informationen über die Chat-Aktivität zu geben. Es wird angemerkt, dass bei Multistream-Events die Zuschauerzahlen auf allen Kanälen gespiegelt werden, aber der Chat zusammengeführt ist, was zu einer erhöhten Chat-Aktivität führt. Es wird festgestellt, dass die Eisbach-Streams zwar mehr Chatnachrichten haben, aber pro Zuschauer sogar weniger, was darauf hindeutet, dass die erhöhte Chat-Aktivität auf die Reichweite zurückzuführen ist und nicht auf ein höheres Engagement der einzelnen Zuschauer. Abschließend wird ein neuer Datensatz hochgeladen, wobei darauf hingewiesen wird, dass die Anzahl der Datensätze für zuverlässige Ergebnisse noch zu gering ist.

KI-gestützte Analyse von Streamer-Daten: Reichweite, Engagement und Multistream-Herausforderungen

02:19:51Die Diskussion dreht sich um die Herausforderungen bei der Interpretation von Streamer-Daten durch KI, insbesondere im Hinblick auf Multistreams und die Unterscheidung zwischen verschiedenen Arten von Zuschauerinteraktionen. Es wird festgestellt, dass die KI möglicherweise nicht erkennt, dass bei einem Multistream die Zuschauerzahlen nur vom eigenen Kanal stammen, während die Chatnachrichten von allen Teilnehmern zusammenkommen. Dies kann zu falschen Schlussfolgerungen über die Chat-Aktivität führen. Es wird auch diskutiert, wie die KI erkennen kann, dass es sich um einen Multistream handelt, um die Daten entsprechend anzupassen. Die Bedeutung der Chat-Aktivität als Indikator für Engagement wird hervorgehoben, wobei festgestellt wird, dass eine höhere Chat-Aktivität auf einen Multistream hindeuten kann. Es wird jedoch auch darauf hingewiesen, dass die Chat-Qualität bei größeren Streams oft schlechter ist, da Nachrichten schneller durchlaufen und mehr Emotes gespammt werden. Trotzdem wird betont, dass jede Interaktion, auch ein einfacher Emote, eine Reaktion auf den Content darstellt und somit im Marketing-Kontext relevant ist. Die Frage, wie transparent die Vorhersage der KI sein muss, wird aufgeworfen, wobei betont wird, dass die Daten aus dem Dashboard der Streamer stammen und von diesen persönlich zugeschickt wurden. Es wird auch diskutiert, ob Sub-Only-Chats berücksichtigt werden müssen, wobei argumentiert wird, dass es letztendlich auf die Engagement-Rate ankommt. Abschließend wird festgestellt, dass ein Stream mit schlechten Zahlen auch schlechte Zuschauerzahlen hat, was sich in den Daten widerspiegelt.

Datenanalyse-Methoden und Herausforderungen bei der Interpretation von Twitch-Daten

02:32:16Die Diskussion fokussiert sich auf die methodischen Herausforderungen und die Interpretation von Twitch-Daten im Kontext von Streaming-Analysen. Ein Kommentator äußert Bedenken hinsichtlich der wissenschaftlichen Fundierung der verwendeten Methoden und vergleicht die Herangehensweise an die Datenerhebung mit der Behandlung einer ernsten Krankheit, was jedoch als unangemessen zurückgewiesen wird. Es wird betont, dass das Ziel der Analyse darin besteht, Zusammenhänge zu verstehen und grobe Schätzungen für Livestreaming-Events zu erstellen, anstatt genaue Zahlen zu liefern. Die Daten stammen direkt von den Streamern und sind nicht frei erfunden. Es wird diskutiert, wie sich das Zuschauerverhalten zwischen kleinen und großen Streamern unterscheidet, wobei festgestellt wird, dass größere Streamer tendenziell eine geringere Watchtime pro Zuschauer haben, aber eine höhere Chat-Aktivität. Es wird auch die Frage aufgeworfen, ob die KI in der Lage ist, den Hype um bestimmte Streams oder Streamer-Duos zu erkennen, was zusätzliche Daten über Kooperationen erfordern würde. Die Schwierigkeit, einen Zusammenhang zwischen der durchschnittlichen Zuschauerzahl (CCV) und anderen Reichweitenkennzahlen wie Live-Aufrufen, Watchtime und einzelnen Zuschauern zu finden, wird thematisiert. Es wird vermutet, dass die Eingaben für die KI möglicherweise nicht präzise genug sind, um die gewünschten Ergebnisse zu erzielen. Abschließend wird beschlossen, die Analyse von vorne zu beginnen und die Ziele klarer zu definieren.

Neustart der Datenanalyse: Zieldefinition, Prompt-Optimierung und Community-Input

03:06:18Nachdem die bisherigen Versuche, mit der KI verwertbare Ergebnisse zu erzielen, nicht zufriedenstellend waren, wird beschlossen, die Datenanalyse von Grund auf neu zu starten. Es wird der Wunsch geäußert, die Zahlen besser zu verstehen und die Prompts für die KI zu optimieren. Das Ziel ist es, einen Forecast für die Reichweite von Livestreaming-Events mit verschiedenen Streamern zu erstellen. Dabei soll die KI in der Lage sein, anhand des Datensatzes Zusammenhänge zu erkennen und Faktoren wie Live-Aufrufe, einzelne Zuschauer und Watchtime zu berücksichtigen. Die Community wird um Input gebeten, wie man die Analyse am besten angeht. Es wird diskutiert, ob man eine lange oder kurze Prompt schreiben soll und ob es sinnvoll ist, zunächst die Ziele klar zu definieren. Es wird betont, dass das Problem in der Verweildauer liegt und dass die KI möglicherweise etwas aus dem Datensatz falsch verstanden hat. Die Frage, ob es einen Zusammenhang zwischen dem CCV (Concurrent Viewers) und den Live-Aufrufen oder einzelnen Zuschauern gibt, wird als zentraler Punkt identifiziert. Es wird festgestellt, dass die bisherigen Prompts möglicherweise zu kompliziert waren und dass es notwendig ist, die Zusammenhänge zwischen den Zahlen zu verstehen, bevor man eine Vorhersage treffen kann. Abschließend wird die Community erneut um Hilfe gebeten, um die nächsten Schritte zu definieren.

Datenleck und Prompt-Erstellung für Livestream-KPIs

03:49:51Es gab einen Vorfall, bei dem versehentlich ein Link zu einem privaten Dokument öffentlich wurde, was zu Unmut führte und dazu veranlasste, die Datei zu löschen und in Zukunft vorsichtiger zu sein. Im weiteren Verlauf des Streams konzentriert sich die Diskussion auf die Erstellung einer Prompt für eine KI, um Marketing-KPIs für Livestreams zu forecasten, wobei lediglich die CCV (Concurrent Viewers) der teilnehmenden Streamer als Datenbasis dient. Es wird über die Formulierung der Anweisungen an die KI diskutiert, wobei verschiedene Vorschläge aus dem Chat eingehen. Die Herausforderung besteht darin, der KI verständlich zu machen, dass sie eine Prompt erstellen soll, die auf den vorhandenen Daten basiert und nicht auf externen Informationen aus dem Internet. Verschiedene Ansätze werden diskutiert, darunter die Verwendung von Mittelwerten und die Berücksichtigung der Chataktivität. Das Ziel ist, eine verlässliche Prompt zu entwickeln, die für die Vorhersage von Livestream-KPIs verwendet werden kann.

KI-gestützte Prompt-Optimierung und Datenanalyse für Livestream-Vorhersagen

04:00:13Die KI liefert erste Ergebnisse, die jedoch aufgrund falscher Eingaben und Annahmen ungenau sind. Es wird festgestellt, dass die KI fälschlicherweise den Peak CCV anstelle des durchschnittlichen CCV verwendet hat. Es wird versucht, die Prompt zu korrigieren und der KI klarzumachen, dass sie sich ausschließlich auf die vorhandenen Daten beschränken soll. Die KI greift jedoch weiterhin auf externe Daten aus dem Internet zu, was als unerwünscht angesehen wird. Es wird beschlossen, die Prompt so anzupassen, dass die KI ausschließlich die Informationen aus dem bereitgestellten Datensatz verwendet. Dieser Datensatz enthält Informationen zu 197 Streams von fünf verschiedenen Streamern, darunter Datum, Chatnachrichten, Zuschauerzahlen und Analysen. Es wird betont, dass das Ziel darin besteht, zu sehen, ob die KI in der Lage ist, auf Basis dieser Daten brauchbare Vorhersagen zu treffen. Die Streamerin experimentiert weiter mit der KI, indem sie verschiedene Streams als Beispiele eingibt, um zu sehen, wie die KI die Daten interpretiert und welche Vorhersagen sie trifft. Die Ergebnisse sind jedoch weiterhin ungenau, was zu Frustration führt. Es wird diskutiert, woran die Ungenauigkeiten liegen könnten, und verschiedene Faktoren werden in Betracht gezogen, darunter die Spannweite der Zuschauerzahlen und die Dauer der Streams.

Herausforderungen bei der Livestream-Vorhersage und Optimierung der KI-Prompt

04:19:55Es wird betont, dass das Ziel nicht darin besteht, eine hundertprozentig genaue Vorhersage zu treffen, sondern einen Wert zu finden, der sich der Realität annähert und im Marketingbereich verwendet werden kann. Die Streamerin experimentiert weiter mit der KI, indem sie verschiedene Streams als Beispiele eingibt und die Ergebnisse mit den tatsächlichen Werten vergleicht. Dabei stellt sie fest, dass die KI oft daneben liegt und die Range zwischen den Vorhersagen und den tatsächlichen Werten zu groß ist. Es wird vermutet, dass dies an der großen Spannweite der durchschnittlichen Zuschauerzahlen liegen könnte, die die KI verwendet. Die Streamerin fragt die KI, woran die großen Abweichungen liegen könnten, und erhält die Antwort, dass der Peak falsch geschätzt wurde. Sie ist jedoch skeptisch, ob der Peak tatsächlich das Problem ist. Stattdessen vermutet sie, dass die Stream-Dauer eine wichtige Rolle spielen könnte. Es wird diskutiert, ob es sinnvoll ist, der KI direkt zu sagen, was sie ändern soll, oder ob man sie selbstständig die Lösung finden lassen soll. Die Streamerin entscheidet sich dafür, die KI weiterhin selbstständig arbeiten zu lassen, um nicht in den gleichen Fehler wie zuvor zu verfallen. Es wird betont, dass das Ziel darin besteht, einen Mittelwert zu finden, der im Marketingbereich verwendbar ist und eine realistische Einschätzung der Reichweite ermöglicht.

Datenbankanalyse und KI-gestützte Prognose für Livestream-Reichweite

04:37:01Die Streamerin erklärt, dass sie über eine umfangreiche Datenbank mit 197 Datensätzen von fünf Streamern verfügt, die reale Daten aus deren Streams enthält. Diese Datenbank soll genutzt werden, um herauszufinden, wie eine potenzielle Stream in der Zukunft performen könnte. Es wird diskutiert, ob es interessant wäre herauszufinden, welche Uhrzeit und welche Art von Streams zu verschiedenen Zuschauerzahlen führen, aber das Hauptziel ist es, die Reichweite eines geplanten Streams anhand der durchschnittlichen Zuschauerzahlen vorherzusagen. Die Streamerin betont, dass sie die KI nicht dazu verwendet, eine Excel-Tabelle auszuwerten, sondern um einen Weg zu finden, anhand der durchschnittlichen Zuschauerzahlen von Twitch-Events, die in der Zukunft stattfinden, die Reichweite zu prognostizieren, unabhängig davon, welcher Streamer daran teilnimmt. Das Ziel ist es, eine Formel zu finden, mit der ein Durchschnittswert ermittelt werden kann, der für alle funktioniert. Es wird erkannt, dass es wichtig ist, nicht zu sehr ins Detail zu gehen und stattdessen einen Mittelwert zu verwenden, um die Komplexität zu reduzieren. Die Streamerin passt die Prompt weiter an und gibt der KI das Feedback, dass die bisherige Range zu groß ist. Sie testet die aktualisierte Prompt mit verschiedenen Beispielen und vergleicht die Ergebnisse mit den tatsächlichen Werten, um die Genauigkeit der Vorhersagen zu überprüfen.

KI-Tool Entwicklung: Fokus auf relevante KPIs und Datenanalyse

05:40:32Die Entwicklung des KI-Tools konzentriert sich auf die relevanten KPIs wie Live-Aufrufe, einzelne Zuschauer, Watchtime und Engagement-Rate, wobei die Engagement-Rate anhand von Chatnachrichten berechnet wird. Der erste Schritt zur Lösung besteht darin, die Korrelation zwischen den einzelnen Werten, insbesondere für jeden Streamer, zu analysieren, um Zusammenhänge zu erkennen. Es wird überlegt, ob eine Korrelation in einer Bandbreite von CCV (Concurrent Viewers) sinnvoller wäre, um Datensätze mit ähnlichen Zuschauerzahlen zu betrachten. Es wird betont, dass zunächst die Zusammenhänge zwischen Streams, Streamern und Zuschauerzahlen verstanden werden müssen, bevor die KI-Erstellung vorangetrieben wird. Die Ausdrucksweise muss konkret genug sein, um eine Prompt zu erstellen, die die benötigten Ergebnisse liefert. Die Streamerin plant eine Nachtschicht, um die Datensätze und Zusammenhänge besser zu verstehen, da die aktuelle Herangehensweise mit ChatGBT nicht die gewünschten Ergebnisse liefert. Es wird diskutiert, dass ein Zusammenhang zwischen Streams mit ähnlichen Zuschauerzahlen bestehen könnte und dass die KI helfen könnte, dies auszudrücken.

Frustration und Lösungsansätze bei der KI-Tool Entwicklung

05:47:09Es wird Frustration über den mangelnden Fortschritt bei der Entwicklung des KI-Tools geäußert, wobei die Schwierigkeit darin besteht, die richtigen Prompts für die KI zu formulieren. Es wird betont, dass es nicht ausreicht, einfach Daten in die KI einzugeben, sondern dass ein tieferes Verständnis der Zusammenhänge erforderlich ist. Die Idee, KI zur Unterstützung bei der Formulierung von Prompts zu nutzen, wird angesprochen. Es wird diskutiert, dass man nicht einfach die Arbeit durch Bezahlung abgeben möchte, sondern es wird bevorzugt, Sachen selber herauszufinden und selber zu lösen. Es wird betont, dass man sich reinfuchsen muss, was funktioniert und was nicht. Es wird betont, dass man nicht schnell aufgeben und Geld reinbuttern will, dass es irgendjemand anderes für mich macht. Es wird auch die Idee einer Zeitreihenanalyse erwähnt. Die Streamerin ist genervt davon, dass sie zu dumm ist, um hier eine Lösung zu finden.

Nebenprojekte und Community-Interaktion

05:50:19Es wird ein Tool namens Halomina erwähnt, das eine Art MyHammer für Livestreaming darstellt, dessen Weiterentwicklung jedoch von der Gründung der GmbH abhängt. Die Streamerin äußert sich erfreut darüber, dass so viele Zuschauer an der Entwicklung des KI-Tools teilnehmen. Es wird erwähnt, dass vergleichbare Tools zwischen 300 und 1000 Euro kosten. Es wird betont, dass man es bei Gründungen nicht so überkompliziert machen muss, da sich die Zahlen sowieso ändern. Es wird angekündigt, dass jede Woche Coworking-Streams stattfinden, bei denen Webseiten, SaaS-Tools und UX-Tests gemeinsam mit ChatGBT erstellt werden. Die Streamerin hofft, dass die Zuschauer beim nächsten Mal auch dabei sind. Es wird überlegt, ob man die Daten von einem anderen Streamer nutzen soll, aber die Streamerin ist mit diesem nicht so dicke, dass sie ihn fragen würde.

Datenanalyse und Tool-Test mit Zuschauerbeteiligung

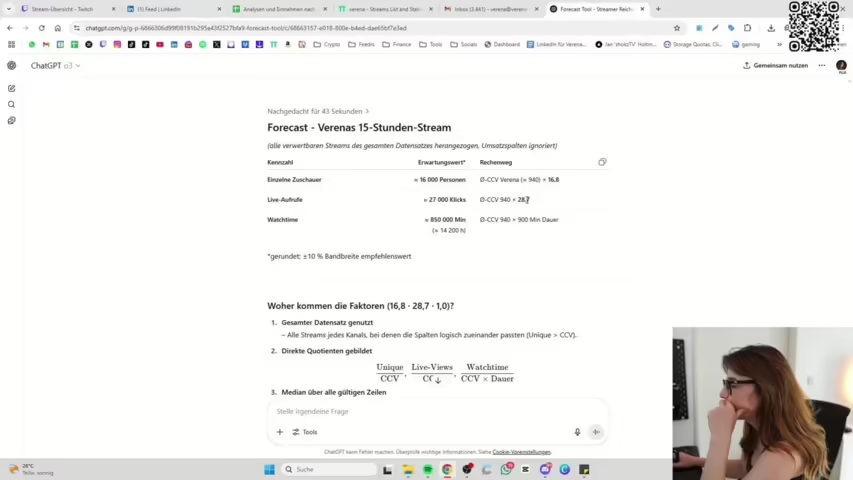

06:01:33Die Streamerin plant, die eigenen Daten in ein Prognose-Tool einzugeben, um dessen Genauigkeit zu testen. Es wird ein Livestream von der Gamescom am 30. Juli 2025 mit einer Streamerin, einer durchschnittlichen Zuschauerzahl von 806 und einer Dauer von 11 Stunden als Testfall für das Tool verwendet. Es wird diskutiert, dass das Datum irrelevant sein könnte, da es nicht um die Zuschauerzahlen aus der Vergangenheit geht, sondern um die Reichweite bei einer bestimmten durchschnittlichen Zuschauerzahl. Die Streamerin gibt die Zahl 806 als durchschnittliche Zuschauerzahl ein, um eine Prognose zu erhalten. Es stellt sich heraus, dass die Watchtime, der CCV, die Live-Aufrufe und die einzelnen Zuschauer falsch sind. Die Streamerin betont, dass die Daten von allen Streamern repräsentativ sein müssen für die Streamer-Daten, die wir nicht haben. Es wird überlegt, ob es einen Zusammenhang zwischen CCV und den Reichweitendaten gibt und wie man diesen hoch- und runter rechnen kann, sodass es für jeden Streamer zählt.

Abschluss der KI-Tool Thematik, Datenzugriff und Idealo Partnerschaft

06:15:08Die Streamerin beendet das Thema KI-Tool und bietet an, den Datensatz (ohne sensible Daten) an Interessierte weiterzugeben. Es stellt sich heraus, dass ein Zuschauer (Föxy) im Google Doc mit den Daten war, was kurzzeitig zu Panik führte, da die Streamerin einen Hack vermutete. Entwarnung: Es war nur Foxy. Die Streamerin geht zum Thema Schuhe über und erwähnt, dass Idealo Placement-Partner des Monats ist und sie massiv dabei unterstützen, geilen Content zu machen. Deswegen bestellt sie ihre Schuhe nur über Idealo. Sie nutzt Idealo auch, um nach der Nintendo Switch 2 zu suchen und Preise zu vergleichen. Es wird die Funktionalität von Idealo hervorgehoben, insbesondere der Preiswecker und die Möglichkeit, Preise im Laden mit der App zu scannen und zu vergleichen. Die Streamerin zeigt, wie man mit der Idealo-App Produkte im Laden abscannen und die günstigsten Preise finden kann. Sie scannt ihre Handcreme ab und vergleicht die Preise.

Idealo App, Schuhkauf und Reisepläne

06:34:15Die Streamerin diskutiert mit dem Chat über den Kauf einer Klimaanlage und stellt fest, dass die Preise aktuell sehr hoch sind. Sie überlegt, ob sie die Schuhe kaufen soll, ist aber unsicher wegen der Farbe und des Modells. Die Streamerin fragt den Chat nach Meinungen zu den Schuhen und erhält unterschiedliche Antworten. Sie entscheidet sich, nur noch auf Frauen zu hören, da sie mit den Meinungen der männlichen Twitch-User nicht zufrieden ist. Es wird über Reisepläne gesprochen, insbesondere eine Reise mit Danny in zwei Wochen. Danny baut das Auto für die Reise um, möglicherweise auch für Übernachtungen. Die Streamerin kündigt an, dass sie möglicherweise morgen früh um 8 Uhr wieder live sein wird, um am Kalkulator-Ding weiterzubauen. Die Streamerin verabschiedet sich und wünscht viel Spaß bei Danny.